Iberoamérica intensifica sus esfuerzos para desarrollar Modelos de Lenguaje de Gran Escala (LLMs, por sus siglas en inglés) que reflejen la riqueza lingüística y cultural del español y el portugués. Varias iniciativas buscan reducir la dependencia de modelos entrenados predominantemente en inglés y promover una inteligencia artificial más inclusiva y representativa de la diversidad de la región.

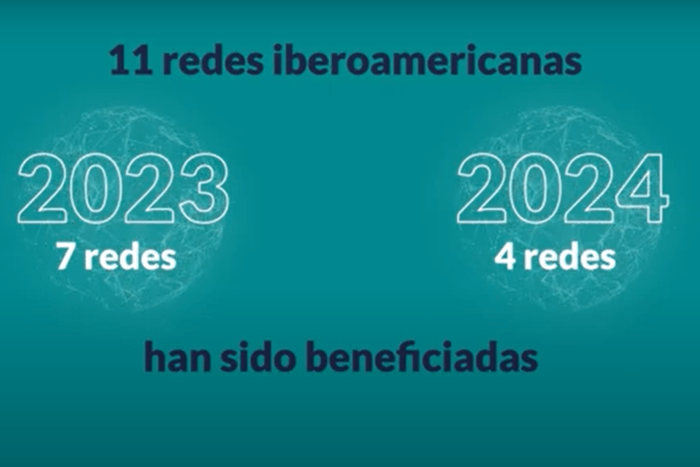

En octubre de 2024, los 22 países de Iberoamérica acordaron colaborar en el desarrollo de un modelo fundacional de lenguaje de inteligencia artificial entrenado en español y portugués para crear una IA más equitativa y adaptada a las realidades de Iberoamérica.

Previo a este anuncio ya existían iniciativas en diversos países de la región como la del Gobierno de España, que en febrero de 2024 anunció la creación de un modelo de IA entrenado completamente en español, en colaboración con el Barcelona Supercomputing Center y la Real Academia Española. La intención: cerrar las brechas lingüísticas y fortalecer la presencia del español y las lenguas cooficiales en el ámbito de la inteligencia artificial.

Apenas un año más tarde, en enero de 2025, se presentaron sus primeros avances: ALIA, una familia de modelos de IA en castellano y lenguas cooficiales que proporciona una infraestructura pública de recursos de inteligencia artificial, fomentando el desarrollo de aplicaciones avanzadas en estas lenguas y reforzando la soberanía tecnológica del país.

Con el mismo objetivo se creó Amazônia IA, un modelo de lenguaje de gran escala desarrollado en Brasil, diseñado específicamente para el portugués brasileño. Widelabs, empresa local de apenas cinco años de vida es el artífice del modelo, cuyo chat está disponible desde agosto de 2024. La tecnología se presentó el mismo día que el Plan Brasileño de Inteligencia Artificial (PBIA) y cuenta con el apoyo del Ministerio de Ciencia, Tecnología e Innovación (MCTI) del país, que lo enfoca como un proyecto de soberanía nacional que busca combatir la fuga de cerebros al abrir nuevas oportunidades para desarrolladores y empresas locales.

Desde entonces Widelabs ha ido añadiendo interfaces de programación (APIs) como Guara, Harpia y Golia -nombres que hacen referencia a animales emblemáticos de la fauna amazónica- hasta el lanzamiento en marzo pasado de Amazônia 360, una evolución de su IA conversacional orientada al desarrollo de aplicaciones y herramientas de inteligencia artificial.

“El modelo se entrena con enormes cantidades de datos nacionales, habilitándolo para comprender y respetar los matices del idioma y la cultura brasileña”, señaló en una reciente entrevista el CEO de Widelabs, Nelson Leoni.

Bajo un objetivo muy similar trabajan las académicas Luciana Benotti (Argentina) y Jocelyn Dunstan (Chile). Ambas coinciden en que el español, el portugués y cualquier lengua precisa modelos de IA propios para evitar perpetuar los valores culturales que inevitablemente incorporan modelos como ChatGPT: los de un hombre blanco, universitario y de origen anglosajón.

Latam GPT, cuya capacidad es equiparable a la de ChatGPT 3.5 de OpenAI, estará disponible en junio de 2025 como un modelo público y abierto para fomentar la investigación y el desarrollo de la IA en la región

La primera es profesora en la Universidad Nacional de Córdoba y especialista en lingüística computacional. Su trabajo aborda cómo los modelos de IA, al ser entrenados con datos predominantemente en inglés y provenientes de contextos específicos, pueden perpetuar sesgos culturales y estereotipos. La académica destaca la necesidad de desarrollar modelos de IA que reflejen la diversidad cultural y lingüística del mundo hispanohablante, evitando la adopción de prejuicios existentes en los datos de entrenamiento. Benotti señala que los gigantes tecnológicos implicados en el desarrollo de la IA se alimentan gratuitamente de los datos que se producen en español. Aspiran toda esa información de Internet para crear modelos comerciales de la misma forma en que se extraían las materias primas para luego devolverlas en formatos de pago, creando “una nueva forma de colonización extractivista”.

Jocelyn Dunstan, investigadora en la Pontificia Universidad Católica de Chile y en el Instituto Milenio Fundamentos de los Datos, centra su trabajo en la creación de modelos de IA adaptados al contexto latinoamericano. Para ella, una de las claves pasa por reconocer y representar las variantes regionales del español para mejorar la precisión y relevancia de las aplicaciones tecnológicas en la región.

Dunstan también participa en la iniciativa Latam GPT, lanzada en febrero de 2025, como modelo de lenguaje de gran escala diseñado para representar con precisión la historia y cultura de Latinoamérica. El proyecto, liderado por el Centro Nacional de Inteligencia Artificial (Cenia) de Chile, cuenta con la colaboración de más de 30 instituciones y 60 expertos de diversos países de la región: Argentina, Colombia, Costa Rica, Ecuador, México, Perú y Uruguay.

Latam GPT, cuya capacidad es equiparable a la de ChatGPT 3.5 de OpenAI, estará disponible en junio de 2025 y se concibe como un modelo público y abierto para fomentar la investigación y el desarrollo de la IA en la región.

Barreras

Los Modelos de Lenguaje de Gran Escala (LLMs)enfrentan diversos obstáculos en la representación de la diversidad lingüística y cultural de Iberoamérica. La principal es la falta de corpus de alta calidad en español y portugués que dificulta la creación de modelos que reflejen adecuadamente sus estructuras gramaticales y particularidades semánticas. Valga un dato: la representación del español en los conjuntos de datos (datasets) que alimentan la IA es solo el 2% de en el caso del español, según la ODCE, y la presencia del portugués es aún menor.

No obstante, la lingüista computacional española Carmen Torrijos señala que “la cantidad de datos empieza a ser cada vez menos importante por dos motivos. Primero, porque los modelos son cada vez mejores tecnológicamente y necesitan menos datos para entrenarse y, segundo, porque se pueden crear datos sintéticos”.

Esto significa que a partir de texto en español mexicano, por ejemplo, se puede generar texto nuevo en español mexicano y hacerlo pasar por datos de entrenamiento.

El problema, según Torrijos, es que “no se trata de datos reales y si no se hace bien podría deteriorarse el modelo al entrar en el bucle infinito de entrenar un modelo de IA con contenidos generados por un modelo de IA. La cantidad de datos para entrenar el modelo es solventable, pero la calidad del modelo puede peligrar y en este punto Chat GPT lleva mucha ventaja. Su capacidad de compresión de prompts, sus respuestas cada vez más acertadas y la mejora del producto digital que rodea al modelo hacen muy difícil competir con él”.

Para que los LLMs representen mejor la diversidad lingüística y cultural de Iberoamérica, es crucial desarrollar infraestructuras propias, crear datasets representativos, reducir la dependencia tecnológica externa y fomentar una colaboración regional efectiva

Otro gran problema es la infrarrepresentación de variedades dialectales y expresiones coloquiales de cada región, un aspecto que afecta a la riqueza de la diversidad lingüística iberoamericana en general y a las lenguas originarias en particular.

En esta línea, el informe de UNESCO Inteligencia artificial centrada en los pueblos indígenas: perspectivas desde América Latina y el Caribe se presenta como “un llamado a la acción para incorporar activa y respetuosamente el lenguaje y las perspectivas de los pueblos indígenas en la IA, apuntando hacia una futura sabiduría colectiva que honre la riqueza de las experiencias y conocimientos humanos”, según expresa en el prólogo la Directora General Adjunta para Ciencias Sociales y Humanas de UNESCO, Gabriela Ramos.

Junto a las dos barreras anteriores, se encuentra la de la pura materialidad: pocas instituciones en la región cuentan con la infraestructura necesaria para entrenar modelos de IA desde cero.

ALIA, Amazônia.IA y LatamGPT fortalecen la presencia del español y el portugués en el ámbito tecnológico global y garantizan que las soluciones de IA sean más inclusivas y representativas de la realidad iberoamericana, pero para que los LLMs representen mejor la diversidad lingüística y cultural de los 22 países, es crucial -coinciden los expertos- desarrollar infraestructuras propias, crear datasets representativos, reducir la dependencia tecnológica externa y fomentar una colaboración regional efectiva.