A Ibero-América intensifica seus esforços para desenvolver Modelos de Linguagem de Grande Escala (LLMs, na sigla em inglês) que reflitam a riqueza linguística e cultural do espanhol e do português. Diversas iniciativas buscam reduzir a dependência de modelos treinados predominantemente em inglês e promover uma inteligência artificial mais inclusiva e representativa da diversidade da região.

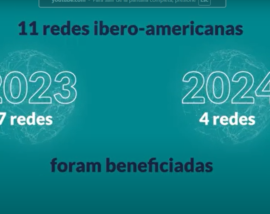

Em outubro de 2024, os 22 países da Ibero-América acordaram colaborar no desenvolvimento de um modelo fundacional de linguagem de inteligência artificial treinando em espanhol e em português para criar uma IA mais equitativa e adaptada às realidades da Ibero-América.

Antes deste anúncio, já existiam iniciativas em diversos países da região, como a do Governo da Espanha, que em fevereiro de 2024 anunciou a criação de um modelo de IA treinado completamente em espanhol, em colaboração com o Barcelona Supercomputing Center e a Real Academia Espanhola. A intenção: fechar as lacunas linguísticas e fortalecer a presença do espanhol e das línguas cooficiais no âmbito da inteligência artificial.

Apenas um ano depois, em janeiro de 2025, foram apresentados os primeiros avanços: ALIA, uma família de modelos de IA em castelhano e línguas cooficiais que fornece uma infraestrutura pública de recursos de inteligência artificial, fomentando o desenvolvimento de aplicações avançadas nessas línguas e reforçando a soberania tecnológica do país.

Com o mesmo objetivo foi criado o Amazônia IA, um modelo de linguagem de grande escala desenvolvido no Brasil, projetado especificamente para o português brasileiro. Widelabs, empresa local de apenas cinco anos de vida é o artífice do modelo, cujo chat está disponível desde agosto de 2024. A tecnologia foi apresentada no mesmo dia que o Plano Brasileiro de Inteligência Artificial (PBIA) e conta com o apoio do Ministério de Ciência, Tecnologia e Inovação (MCTI) do país, que o enfoca como um projeto de soberania nacional que busca combater a fuga de cérebros ao abrir novas oportunidades para desenvolvedores e empresas locais.

Desde então, a Widelabs vem adicionando interfaces de programação (APIs) como Guara, Harpia e Golia – nomes que fazem referência a animais emblemáticos da fauna amazônica – até o lançamento, em março passado, da Amazônia 360, uma evolução de sua IA conversacional orientada ao desenvolvimento de aplicações e ferramentas de inteligência artificial.

“O modelo é treinado com enormes quantidades de dados nacionais, habilitando-o para compreender e respeitar as nuances do idioma e a cultura brasileira”, assinalou em uma recente entrevista o CEO da Widelabs, Nelson Leoni.

Sob um objetivo muito similar trabalham as acadêmicas Luciana Benotti (Argentina) e Jocelyn Dunstan (Chile). Ambas coincidem que o espanhol, o português e qualquer outra língua precisam de modelos próprios de IA para evitar perpetuar os valores culturais que, inevitavelmente, são incorporados por modelos como o ChatGPT: os de um homem branco, universitário e de origem anglo-saxã.

Latam GPT, cuja capacidade é equiparável à do ChatGPT 3.5 da OpenAI, estará disponível em junho de 2025 como um modelo público e aberto para fomentar a pesquisa e o desenvolvimento da IA na região

A primeira é professora na Universidade Nacional de Córdoba e especialista em linguística computacional. Seu trabalho aborda como os modelos de IA, ao serem treinados com dados predominantemente em inglês e provenientes de contextos específicos, podem perpetuar vieses culturais e estereótipos. A acadêmica destaca a necessidade de desenvolver modelos de IA que reflitam a diversidade cultural e linguística do mundo hispanofalante, evitando a adoção de preconceitos existentes nos dados de treinamento. Benotti aponta que os gigantes tecnológicos envolvidos no desenvolvimento da IA se alimentam gratuitamente dos dados produzidos em espanhol. Aspiram toda essa informação da Internet para criar modelos comerciais da mesma forma que se extraíam matérias-primas, para depois devolvê-las em formatos pagos, criando “uma nova forma de colonização extrativista”.

Jocelyn Dunstan, pesquisadora na Pontifícia Universidade Católica do Chile e no Instituto Milênio Fundamentos dos Dados, centra seu trabalho na criação de modelos de IA adaptados ao contexto latino-americano. Para ela, uma das chaves está em reconhecer e representar as variantes regionais do espanhol para melhorar a precisão e a relevância das aplicações tecnológicas na região.

Dunstan também participa na iniciativa Latam GPT, lançada em fevereiro de 2025, como modelo de linguagem de grande escala projetado para representar com precisão a história e a cultura da América Latina. O projeto, liderado pelo Centro Nacional de Inteligência Artificial (Cenia) do Chile, conta com a colaboração de mais de 30 instituições e 60 especialistas de diversos países da região: Argentina, Colômbia, Costa Rica, Equador, México, Peru e Uruguai.

Latam GPT, cuja capacidade é equiparável à do ChatGPT 3.5 da OpenAI, estará disponível em junho de 2025 e se concebe como um modelo público e aberto para fomentar a pesquisa e o desenvolvimento da IA na região.

Barreiras

Os Modelos de Linguagem de Grande Escala (LLMs) enfrentam diversos obstáculos na representação da diversidade linguística e cultural da Ibero-América. O principal é a falta de corpus de alta qualidade em espanhol e português, o que dificulta a criação de modelos que reflitam adequadamente suas estruturas gramaticais e particularidades semânticas. Vale um dado: a representação do espanhol nos conjuntos de dados (datasets) que alimentam a IA é de apenas 2%, segundo a ODCE, e a presença do português é menor ainda.

No entanto, a linguista computacional espanhola Carmen Torrijos aponta que “a quantidade de dados começa a ser cada vez menos importante por dois motivos. Primeiro, porque os modelos estão cada vez melhores tecnologicamente e precisam de menos dados para serem treinados e, segundo, porque é possível criar dados sintéticos”.

Isso significa que, a partir de um texto em espanhol mexicano, por exemplo, é possível gerar novo texto em espanhol mexicano e utilizá-lo como dados de treinamento.

O problema, segundo Torrijos, é que “não se trata de dados reais e, se não for bem feito, o modelo pode se deteriorar ao entrar no ciclo infinito de treinar um modelo de IA com conteúdos gerados por um modelo de IA. A quantidade de dados para treinar o modelo é solucionável, mas a qualidade do modelo pode ficar em risco, e nesse ponto o ChatGPT leva muita vantagem. Sua capacidade de compreensão de prompts, suas respostas cada vez mais precisas e a melhoria do produto digital que envolve o modelo tornam muito difícil competir com ele”.

Para que os LLMs representem melhor a diversidade linguística e cultural da Ibero-América, é fundamental desenvolver infraestruturas próprias, criar datasets representativos, reduzir a dependência tecnológica externa e fomentar uma colaboração regional efetiva

Outro grande problema é a sub-representação das variedades dialetais e das expressões coloquiais de cada região, um aspecto que afeta a riqueza da diversidade linguística ibero-americana em geral e das línguas originárias em particular.

Nesta linha, o relatório da UNESCO Inteligência artificial centrada nos povos indígenas: perspectivas desde a América Latina e o Caribe se apresenta como “um chamado à ação para incorporar de forma ativa e respeitosa a linguagem e as perspectivas dos povos indígenas na IA, apontando para uma futura sabedoria coletiva que honre a riqueza das experiências e dos conhecimentos humanos”, conforme expressa no prefácio a Diretora-Geral Adjunta para Ciências Sociais e Humanas da UNESCO, Gabriela Ramos.

Junto às duas barreiras anteriores, encontra-se a da pura materialidade: poucas instituições na região contam com a infraestrutura necessária para treinar modelos de IA desde zero.

ALIA, Amazônia.IA e LatamGPT fortalecem a presença do espanhol e do português no âmbito tecnológico global e garantem que as soluções de IA sejam mais inclusivas e representativas da realidade ibero-americana, mas para que os LLMs representem melhor a diversidade linguística e cultural dos 22 países, é fundamental -coincidem os especialistas- desenvolver infraestruturas próprias, criar datasets representativos, reduzir a dependência tecnológica externa e fomentar uma colaboração regional efetiva.